大数据分析应该掌握哪些基础知识?

随着互联网行业的不断发展。很多人想要从事互联网方面的工作,现在非常流行的就是大数据,你了解大数据是做什么的吗?学习大数据需要掌握哪些知识?大数据在未来有很大的发展机会,每个岗位需要具备的能力是不同的。下面小编为大家介绍学习大数据需要掌握的知识。

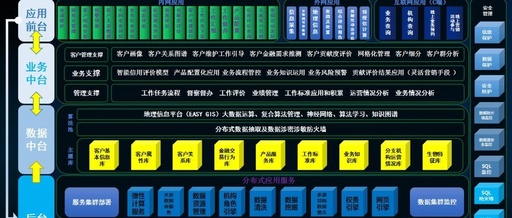

大数据业务流程有四个基本步骤,即业务理解,数据准备,数据挖掘和分析应用程序。该过程分为三个功能区:大数据系统开发,整个操作系统的构建和维护,数据准备,平台和工具开发。大数据挖掘,负责关键模型应用和研究工作。大数据分析应用程序:两者都是外部需求的访问者也是解决方案的输出,并且在许多情况下还将承担整体协调的作用。

大数据提取转换和加载过程(ETL)是大数据的重要处理环节。提取是从业务数据库中提取数据。转换是根据业务逻辑规则处理数据的过程。负载是将数据加载到数据仓库的过程中。

数据提取工具实现了db到hdfs的数据导入功能,并提供了高效的分布式并行处理能力。可以使用数据库分区,字段分区和基于分页的并行批处理将db数据提取到hdfs文件系统中,从而可以有效地按字段解析分区数据。

数据收集可以是历史数据采集或实时数据采集。它可以收集存储在数据库中的结构化数据,或收集非结构化数据,如文本,图片,图像,音频,视频等。结构变化较大的半结构化数据,可以在数据后直接存储在流量状态分析平台上收集完成。

关于如何去学Hadoop,需要哪些基础知识来支撑

在平台方面,hadoop环境需要搭建在linux服务器上,首先需要了解Linux的基础知识与命令;

开发方面,hadoop首先是个提供大数据存储的平台,因此我们要使用其存储功能,因此需要掌握其数据操作的api(scala api 或者 java api);其次是hadoop是大数据分析的数据源,熟悉对大数据的 分析/使用 方法(spark/map-reduce技术,都有scala 和 java两种api)。

因此,学习hadoop必须掌握scala或者java中的一门开发语言,然后在学习hadoop数据操作命令,api,spark/map-reduce分析技术。

另外,还可以学习hbase这种基于hdfs的结构化大数据存储技术,和flume大数据采集技术。